Harry Potter serijal naviknuo je svijet na ideju živih portreta svojim slikama koje govore i pokretnim fotografijama. Ali prošli tjedan, kada je Mona Lisa, Leonardo da Vincijeva „ Mona Lisa “ koju je stvorio AI, počela praviti runde na internetu, mnogi su se iznenadili kad je poznati portret pomaknuo usne i pogledao oko sebe.

Animirani portret Lise Gherardini bio je jedan od nekoliko novih modela „glave za razgovor“ - poznatijih kao „deepfakes“ - koje su izradili istraživači iz Samsung-ovog AI centra u Moskvi i Instituta za znanost i tehnologiju Skolkovo. Koristeći samo nekoliko referentnih okvira ili čak jednu sliku, istraživači su također napravili duboke slike slavnih osoba poput Oprah, oživjeli pojedinačne snimke Marilyn Monroe i Alberta Einsteina i stvorili nove izraze za poznate slike poput Vermeerove djevojke s bisernom naušnicom .

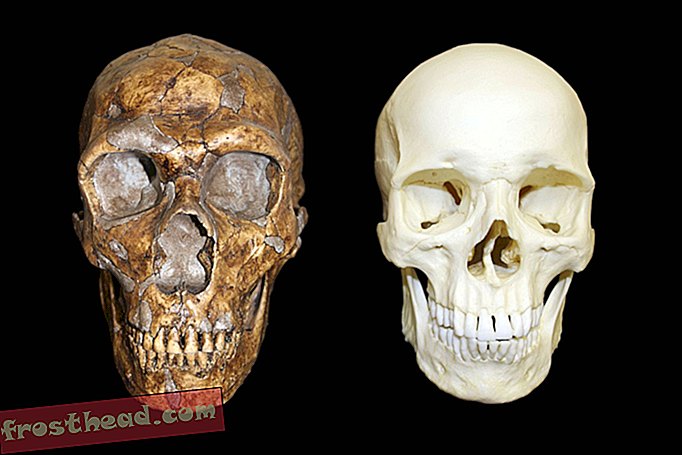

Istraživači su svoju metodu, koju nazivaju „malo snimljeno učenje“, objavili na YouTubeu i u radu koji tek treba proći kroz repozitorij pre-print arXiv.org. Iako su detalji prilično tehnički, Mindy Weisberger iz LiveSciencea izvještava da se za stvaranje živih portreta vrsta umjetne inteligencije koja se naziva konvolucionarna neuronska mreža trenira analizirajući referentne slike. Zatim primjenjuje pokrete lica iz niza okvira na statičku sliku, poput Mona Lise . Što više kutova i referentnih slika ima, bolji je živi portret. Prema radu, AI je mogao proizvesti "savršen realizam" (mjeren ljudskom sposobnošću da razabere koja su od tri skupa slika bila duboka svjetlost) koristeći samo 32 referentne slike.

Mona Lisa je, naravno, samo jedna slika, pa su tri "živa portreta" Leonardovog remek-djela pomalo uznemirujuća. Za kratke animacije, neuronska mreža primijetila je tri različita video zapisa o treningu, a tri verzije Mona Lise na temelju tih okvira čini se da imaju različite osobnosti. Da je Leonardo naslikao svoj poznati model iz različitih uglova, sustav bi mogao stvoriti još realističniji živi portret.

Dok se animirana Mona Lisa zabavlja, porast dubokih fokusa stvorio je zabrinutost da bi se računalno generirane ličnosti mogle upotrijebiti za obmanjivanje ljudi, poticanje rasne ili političke tenzije i dodatno urušavanje povjerenja u internetske medije. "[T] hej potkopavaju naše povjerenje u sve videozapise, uključujući i one koji su originalni", piše John Villasenor iz The Brookings Institution. "I sama istina postaje neuhvatljiva, jer više ne možemo biti sigurni u ono što je stvarno, a što nije."

Dok se AI koristi za stvaranje dubinskih zvukova, Villasenor kaže da se, bar za sada, može upotrijebiti za prepoznavanje dubinskih zvukova pretraživanjem nedosljednosti koje ljudskom oku nisu očite.

Tim Hwang, direktor Harvard-MIT-ove etike i upravljanja AI-inicijativom, kaže Gregoryu Barberu na Wiredu da još uvijek nismo na mjestu gdje loši glumci mogu stvoriti sofisticirane duboke zvukove na svojim osobnim prijenosnim računalima. "Ništa mi ne sugerira da ćete samo koristiti" ključ u ruke "za generiranje dubinskih zvukova kod kuće", kaže on. "Ne kratkoročno, srednjoročno ili čak dugoročno."

To je zato što je korištenje Samsungovog novog sustava skupo i zahtijeva stručnost. No, Barberov članak ističe da ne treba superprefinjen fotorealističan videozapis napravljen od strane neuronske mreže kako bi prevario ljude. Prošlog je tjedna na društvenim mrežama kružio izmanipulirani videozapis koji je usporio kako bi predsjednica američkog doma Nancy Pelosi zvučala pijana.

No na kraju će tehnologija biti dovoljno dobra da će loši glumci biti u stanju stvoriti duboke snimke tako uvjerljive da ih se neće moći prepoznati. Kad dođe taj dan, Hwang kaže Wiredu, ljudi će se morati osloniti na tragove provjere činjenica i kontekstualne tragove kako bi riješili što je stvarno, a što lažno. Na primjer, ako osmijeh Mone Lise uskog osmijeha postane zuban smijeh i ona vam pokuša prodati izbjeljujuću pastu za zube, to je sigurno duboka torba.